مدیریت

مدیریت دسترسی رباتها به بخشهای مختلف سایت

مدیریت دسترسی رباتها به بخشهای مختلف سایت

مدیریت دسترسی رباتها به بخشهای مختلف سایت

همانطور که میدانید، معرفی کامل یک سایت به موتورهای جستجو، بر عهده رباتهای آن موتور جستجو است. گوگل هم به عنوان بزرگترین و گستردهترین شبکه در این زمینه، رباتهای زیادی گسترش داده است که وبمسترهای موفق، همواره مطابق با تغییرات عملکرد آنها پیشروی میکنند. اما رباتهای یک سایت چگونه به قسمتهای گوناگون دسترسی پیدا میکنند و آیا میتوان دسترسی رباتها را به برخی صفحات خاص و برخی محتواهای سایت محدود کرد؟

استفاده از یک فایل متنی با نام Robots.txt تکنیکی است که در این موقعیتها، مورد استفاده قرار میگیرد. در این مطلب از شرکا طراحی حرفه ای وب ایده پویا همراه ما باشید تا شما را با ماهیت فایل Robots.txt آشنا کنیم و به شما بگوییم که اهمیت و بهینهسازی این فایل، چه نقش مهمی میتواند در پیشرفت سایت اینترنتی شما داشته باشد.

فایل Robots.txt چیست؟

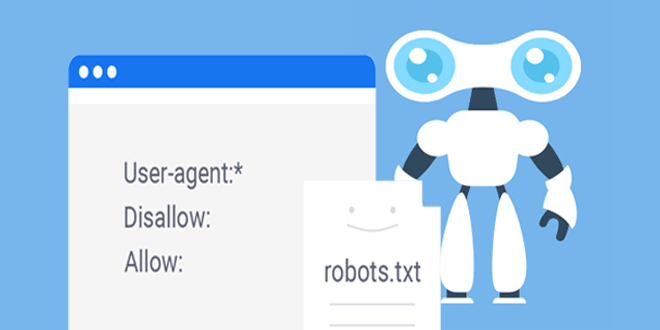

در واقع فایل Robots.txt به رباتهای موتورهای جستجو، مجوز ورود به صفحات مختلف سایت را میدهد. این بدان معنا است که رباتها برای دسترسی به بخشهای گوناگون سایت محدودیت دارند. با این امکان، وبمسترها میتوانند قسمتهایی از سایت را که نمیخواهند در اختیار عموم کاربران قرار گیرد، محدود کنند.

فایل Robots.txt یک فایل متنی ساده است که در مسیر اصلی فضای سایت یا روی دایرکتوری قرار میگیرد و وظیفه آن، معرفی بحثهای قابل دسترس و با محدودیت دسترسی برای رباتها و خزندههای گوگل است. شما با دستورات مورد نظر خود در فایل Robots.txt به طور کامل مشخص میکنید که رباتهای موتورهای جستجو کدام صفحات را ایندکس کنند. البته این تنها کاربرد این فایل نیست. از دیگر مزایای آن میتوان به بهبود عملکرد سایت و مدیریت لینکها نیز اشاره کرد.

چرا Robots.txt اهمیت دارد؟

آدرس دسترسی به Robots.txt به صورت زیر است:

www.Your website.com/robots.txt

این یک فایل متنی ساده است که در روت اصلی هاست قرار میگیرد و اگر سایت شما آن را نداشته باشد، بدین معنی است که هیچ محدودیتی برای رباتهای موتورهای جستجو قائل نشدهاید و آنها خیلی راحت میتوانند به تمام صفحات سایت شما دسترسی داشته باشند. این فایل متنی باید فرمت استاندارد و صحیحی داشته باشد و اطلاعات و دستورات داخل آن به آسانی قابل شناسایی باشند. در غیر اینصورت با وجود این فایل متنی برای سایت، باز هم رباتهای موتورهای جستجو به اطلاعات شما دسترسی پیدا کرده و تمام محتوای سایت را ایندکس میکنند. پس فقط در حالتی رباتها محدودیت دسترسی دارند که به طور دقیق در فایل Robots.txt دستوری دریافت کنند که منجر به تغییر رفتار آنها شود.

مدیریت دسترسی رباتها به بخشهای مختلف سایت

ممکن است این سوال برای شما پیش آمده باشد که اصلا چرا برخی از صفحات سایت نباید توسط رباتها ایندکس شوند؟ برای پاسخ به این سوال باید بدانید که گاهی اوقات ایندکس شدن بخشهایی از سایت، نتایج ناخوشایندی به همراه دارد؛ مثل انتشار مطالبی که قوانین موتورهای جستجو را زیر پا میگذارند. همچنین در میان تمام صفحات و مطالب یک سایت، ممکن است صفحههایی یافت شوند که ایندکس شدن آنها هیچ تاثیری در رتبه شما در نتایج گوگل نداشته باشد و عملا نیازی به پدیدار شدن آنها در نتایج جستجو نباشد. در هر حال، شما با کمک فایل Robots.txt میتوانید سایت خود را مدیریت کرده و دسترسی رباتهای موتورهای جستجوی آن را محدود سازید.

فایل Robots.txt چگونه به بهبود عملکرد سایت کمک میکند؟

تا اینجا ذکر کردیم که که سایتها همواره به وسیله موتورهای جستجو بررسی میشوند و مورد بازدید قرار میگیرند. وظیفه رباتها این است که ابتدا اطلاعات را مورد بررسی قرار داده و سپس ایندکس کنند. قطعا حجم بالای رباتها و ترافیکی که کاربران ایجاد میکنند، در این زمینه مشکلساز خواهد بود. در این میان، استفاده از فایل Robots.txt راهحلی موثر برای محدود کردن دسترسی رباتها به بخشهای مشخص شده و قسمتهایی است که ایندکس شدن آنها اهمیت چندانی در سایت ندارد. وقتی ترافیک کمتر باشد، سرور سایت عملکرد بهتری ارائه میکند و ایندکس کردن صفحات توسط رباتها با سرعت بالاتری انجام میگیرد.

مدیریت لینکها با فایل Robots.txt

گفتیم که یکی دیگر از مزایای فایل Robots.txt مدیریت لینکها و URL هاست. Cloaking به روشی گفته میشود که مطالب و URLها را به طرق مختلف در اختیار کاربران انسانی و موتورهای جستجو قرار میدهد. در واقع سئوکاران با استفاده از این تکنیک، دستوراتی را به سرچ کنسول ارائه میدهند تا توسط آن، نتایج گوناگونی برای کاربران موتورهای جستجو به نمایش درآورده شود.

مخفی کردن آدرس صفحات با URL Cloaking باعث میشود که برخی لینکها در نتایج جستجو دیده نشوند و خزندههای موتورهای جستجو نتوانند آنها را کراول کنند. این روش نوعی تکنیک سئو است تا آدرس برخی صفحات از دید کاربران و موتورهای جستجو پنهان شود. با این حال اگر میخواهید که قوانین موتورهای جستجو را نقض نکنید و مشمول جریمههای گوگل نشوید، این کار حتماً باید توسط افراد ماهر انجام گیرد.

یکی دیگر از لینکهایی که بیشترین استفاده از این فایل متنی را دارد، لینکهای مربوط به افیلیت مارکتینگ یا همکاری در فروش است. افیلیت مارکتینگ یکی از روشهای جذاب برای بازاریابی محسوب میشود و طی سالهای اخیر بسیار محبوب و فراگیر شده است. با مدیریت لینکهای ایجاد شده در سیستم افیلیت مارکتینگ، میتوانید آدرس آنها را مخفی کنید.

مهمترین دستورات فایل Robots.txt کدامند؟

دستورات فایل متنی Robots.txt شامل موارد زیر میشوند:

- User-agent

- Allow & Disallow

- Crawl-delay

- Site map

User-agent

این دستور مشخص میکند که یک ربات یا خزنده خاص، امکان دسترسی به بخشهای مختلف سایت را دارد یا خیر. شما با دستورالعمل User-agent میتوانید یا به تمام رباتها اجازه دسترسی بدهید، یا اینکه فقط با افزودن نام یک ربات خاص، آن ربات را از دسترسی به بخشهایی از سایت محدود کنید و یا اجازه دهید بررسی خود را انجام دهد.

به عنوان مثال، فرض کنید که یک ربات وارد سایت شما شده و میخواهد اطلاعات را از یک صفحه خاص جمعآوری کند. این ربات پیش از آنکه وارد صفحه شود، ابتدا فایل robots.txt را چک کرده و سپس صفحه را بررسی میکند.

- User-agentبه این معناست که تمام بخشهای سایت برای رباتها و خزندگان موتورهای جستجو قابل دسترسی هستند. در صورتی که قصد داشته باشید اطلاعات محرمانه خود را فقط برای یک ربات خاص مشخص کنید، باید به جای ستاره، نام دقیق آن ربات را جایگزین نمایید. در این صورت فقط آن ربات اجازه دسترسی به صفحات سایت شما را دارد.

Disallow & Allow

پس از آنکه با دستورالعمل User-agent مشخص شد که کدام رباتها اجازه دسترسی به سایت را دارند، با Disallow & Allow میتوان تعیین کرد که این رباتها کدام صفحات را ایندکس کنند. گزینه Allow به معنای امکان دسترسی و کد Disallow به منزله محدودسازی دسترسی رباتها است.

اگر میخواهید به تمام رباتها دسترسی کامل بدهید، باید کد Allow را در فایل Robot.txt درج نمایید. با این کار به رباتها اعلام میشود که هر صفحهای را که بخواهند میتوانند بازدید و ایندکس کنند. به طور برعکس، با درجه دستور Disallow در فایل robots.txt، به رباتها میفهمانید که اجازه بازدید از هیچ صفحهای در این سایت را ندارند.

همچنین شما با دستور Disallow & Allow این امکان را دارید که فایلها، مسیرها و آدرسهای خود را به صورت انتخابی در دسترس قرار دهید. مثلاً مواردی که کد Disallow در کنار آنها درج شده است، برای دسترسی رباتها محدود هستند و مواردی هم که قبل از آن کد Allow وجود دارد، قابل دسترس خواهند بود. بدین ترتیب خیلی راحت و سریع می توان تمام دسترسیها را با این دستورات، مدیریت کرد.

Crawl-delay

دستورالعمل Crawl-delay یا نرخ تاخیر، این امکان را برای شما فراهم میسازد تا به رباتهای موتورهای جستجو بگویید که بررسی و ایندکس صفحات را به نوبت و با مقدار زمان مشخص شده توسط شما انجام دهند. به عنوان مثال، با قرار دادن این کد در فایل robot.txt شما به برخی موتورهای جستجو مثل بینگ و یاهو اعلام میکنید که بعد از ایندکس هر صفحه، 10 ثانیه صبر کنند و سپس ایندکس صفحه بعدی را شروع نمایند. البته عدد 10 ثانیه قابل تغییر است و میتواند مطابق با خواست شما کم یا زیاد شود.

Site map

دستورالعمل سایت مپ یا نقشه سایت، به موتورهای جستجو میفهماند که فایل XML نقشه سایت را چگونه پیدا کرده است. با اینکه برای ثبت نقشه سایت در موتورهای جستجو روشهای متعددی مثل از ابزارهای وبمستری موتورهای جستجو وجود دارد، اما این راه یکی از روشهای آسان و کم دردسر است. با این حال، زمانی که تصمیم به استفاده از این روش گرفتید، کد دستوری زیر را در فایل robots.txt اضافه کنید.

Site map: https:// example.com/ site map.xml

همانطور که در مثال بالا هم کاملاً مشخص است، باید آدرس دقیق نقشه سایت در آن وارد شود.

چگونه فایل robots.txt بسازیم؟

پیش از ساخت فایل robots.txt ابتدا بررسی کنید که این فایل متنی در سرور سایت شما وجود دارد یا خیر. برای مشخص شدن این موضوع، آدرس www. Example.com/robots.txt را تایپ کنید. اگر ارور 404 به شما نشان داده شد، بدین معنی است که این فایل قبلا ساخته نشده است.

برای ساخت یک فایل متنی، در لاین اول user agent قرار دارد که به شما میگوید میخواهید از کدام سایت جستجوگر استفاده کنید. در صورتی که میخواهید از گوگل کمک بگیرید، باید در جلوی آن googlebot درج شود؛ اما اگر میخواهید همه رباتها اجازه دسترسی به سایت شما را داشته باشند، قبل از آن علامت استار را قرار دهید. در مرحله بعدی باید کدهای Allow و Disallow نوشته شوند.

استفاده از این کدها برای مواقعی است مدیران سایتها دوست نداشته باشند گوگل به تمام قسمتهای سایت آنان دسترسی پیدا کند؛ بنابراین یک محدودیت و حریم برای آن قائل میشوند. لازم است بدانید که اگر میخواهید سایت شما به طور کامل در گوگل نمایش داده شود، باید نقشه سایت را در robots.txt قرار دهید تا گوگل بتواند به نقشه سایت شما دسترسی داشته و محدودیتها را برای بازدیدکنندگان از سایت نمایش دهد.

نکات مهم در رابطه با robots.txt و سئو سایت

همانطور که گفتیم، استفاده مناسب از دستور robots.txt تاثیر مثبتی در کمپین سئو سایت شما دارد. البته اشتباه در این زمینه و یا زیادهروی در آن، میتواند تاثیر معکوس داشته و نتایج ناخوشایندی به بار آورد. به همین منظور، رعایت یکسری نکات برای تهیه یک فایل robots.txt مناسب و منطبق با استانداردهای سئو ضروری است.

1- ابتدا فایل robots.txt خود را تست کنید تا اطمینان حاصل شود که بخشهای مهم سایت شما از طریق دستورات آن مسدود نشده باشند.

2- دقت کنید که فایلها و پوشههای مهم CSS و JS بلاک نشوند؛ زیرا در غیر این صورت ممکن است سایت شما به طور مناسب بارگذاری نشود یا در ایندکس شدن صفحات، اختلال به وجود بیاید.

- 112

- 0

نظرات کاربران (0)